Living on the Edge

Google Kubernetes Engine makes edge computing finally real

Author: Markku Tuomala, CTO

Edge computing has been an unkept promise of 5G networks for years. Industrial companies, energy and utilities, and transportation and logistics businesses have been longing for low-latency services that would allow them to monitor and react in real-time to happenings on the field. Telecom operators, in turn, have dreamt of a genuinely novel business case for their 5G network investments, in which they would offer a scalable, cost-effective edge computing solution as a service to their customers.

Google Cloud’s packaged tools enable Edge as a Service

Edge computing is the practice of processing data closer to the source rather than relying solely on centralized cloud data centers. It offers a range of practical benefits, such as reducing latency, enhancing real-time data processing, and improving system performance. The most mentioned use cases of edge computing are real-time monitoring and control of manufacturing processes, automation of production lines, fleet management, and employee safety.

Two concepts are essential to understanding the hurdles that have been blocking the widespread use of edge computing: containerization and Kubernetes. Containerization involves packaging an application and all its dependencies into a lightweight, portable unit called a container. This allows the application to run consistently across different devices, making it ideal for deployment on edge devices with limited computing capacity. Kubernetes, in turn, acts as a management system for these containers, orchestrating their deployment, scaling, and operation to ensure they run smoothly and efficiently. Jointly, containerization and Kubernetes enable efficient, scalable, and reliable edge computing by ensuring applications can be easily deployed and managed across numerous edge locations.

Managing containerized applications with Kubernetes is a complex technological endeavor that has been a showstopper for many interesting edge computing use cases until recently. In late 2023, however, Google launched a managed service called Google Kubernetes Engine (GKE) Enterprise that will revolutionize the opportunities to offer and deploy edge computing.

Google Kubernetes Engine Enterprise for multitenant edge computing

GKE Enterprise is a tool for managing multitenant edge environments where you can cost-effectively and safely offer computing capacity from the edge for several users. These users can be the manufacturing sites of a single corporation in the same geographical area or a group of clients of a telecom operator or water or electricity company. By using GKE Enterprise, companies can efficiently manage workloads across cloud and edge environments, ensuring seamless operation and high safety availability of applications that require extremely short latency.

Chicken and egg: are use cases awaiting the technology or vice versa?

Some have claimed that edge computing is a fad, as the network connections with 30 – 60 ms latencies in the Nordics, especially, are supposedly enough for 90% of the use cases. The ambitious goal of edge computing to diminish the latency to less than ten milliseconds. This will enable some examples described above, which cannot be realized over the current networks. From my experience, I am convinced that when the appropriately priced chicken is available, the application eggs will follow in numbers. In other words, when the cost of the mature platform technology is on the right level, the game-changing use cases and applications will follow.

Aiming at <10 millisecond latencies

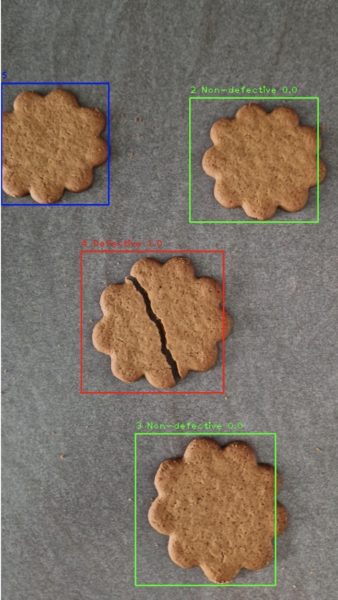

We at Codento have talked with more than a hundred organizations about their plans and aspirations for using artificial intelligence. Customers have delightfully novel ideas for using video surveillance connected to AI, e.g., for identifying the crossing paths of an autonomous forklift and a maintenance worker. With real-time video and a predicting AI solution, a system could reach the upcoming incident faster than a human can, potentially saving the worker’s life.

Last week, we were thrilled to introduce our first customer case in this area to the world. Telecom operator Telia and Codento have collaborated to make edge computing available to Nordic organizations through Telia’s Sirius innovation platform, with ferry operator Finferries being the first customer to pilot the service.

Edge computing transforms industries by enabling secure, low-latency, real-time data processing. For Nordic telecom operators and industrial companies, Google Kubernetes Engine Enterprise offers a powerful platform to harness its benefits.

Codento’s expert team has extensive experience with industrial customers’ businesses and processes, in-depth understanding of the AI-related use cases that Nordic companies are investigating, and awarded capabilities in Google Cloud technologies. We are eager and prepared to help your organization fully utilize edge computing and its applications. Be it a solution you want to build for your use or a platform you want to offer as a service to your customers, we are here to help.

Key takeaways:

- Edge computing will enable novel use cases like video monitoring and real-time reactions to events in, e.g., industrial processes

- Google Kubernetes Engine Enterprise is a solution enabling multitenant edge computing environments, adding scalability, cost, and security to “Edge as a Service”

- Codento can help industrial corporations or telecom, water or electricity companies to build use cases and services based on edge computing

About the author:

Markku Tuomala, CTO, joined Codento in 2021. Markku has 25 years of experience in software development and cloud from Elisa, the leading telecom operator in Finland. Markku was responsible for Telco and IT services cloudification strategy and was a member of Elisa’s production management team. Key tasks included Elisa software strategy and operational services setup for business critical IT outsourcing. Markku drove customer oriented development and was instrumental in business growth to Elisa Viihde, Kirja, Lompakko, Self Services and Network automation. Markku also led Elisa data center operations transformation to DevOps.

Stay tuned for more detailed information and examples of the use cases! If you need more information about specific scenarios or want to schedule a free workshop to explore the opportunities in your organization, feel free to reach out to us.

ctively participating to the event in Las Vegas with Ulf Sandlund and Markku Pulkkinen and remotely via the entire Codento team. Earlier on Tuesday Codento was awarded as

ctively participating to the event in Las Vegas with Ulf Sandlund and Markku Pulkkinen and remotely via the entire Codento team. Earlier on Tuesday Codento was awarded as  ng embedded across a broad range of Google Cloud services addressing a variety of use cases and becoming a true differentiator, for example:

ng embedded across a broad range of Google Cloud services addressing a variety of use cases and becoming a true differentiator, for example:

What is already known convinces us that Google Cloud and its AI approach continues to be completely enterprise-ready providing capabilities to support deployments from pilot to production.

What is already known convinces us that Google Cloud and its AI approach continues to be completely enterprise-ready providing capabilities to support deployments from pilot to production.

Codento osallistui kuuden hengen tiimin kanssa Google Cloud Nordic Summit -tapahtumaan 19.–20.9.2023, jossa meillä oli mahdollisuus tutustua uusimpiin trendeihin ja kehitykseen pilvipalveluissa.

Codento osallistui kuuden hengen tiimin kanssa Google Cloud Nordic Summit -tapahtumaan 19.–20.9.2023, jossa meillä oli mahdollisuus tutustua uusimpiin trendeihin ja kehitykseen pilvipalveluissa. Konferenssissa Google Cloud ilmoitti, että sen GenAI-työkalusarja on valmis laajempiin toteutuksiin. Tämä on merkittävä virstanpylväs, koska se tarkoittaa, että GenAI ei ole enää vain tutkimusprojekti, vaan teknologia, joka

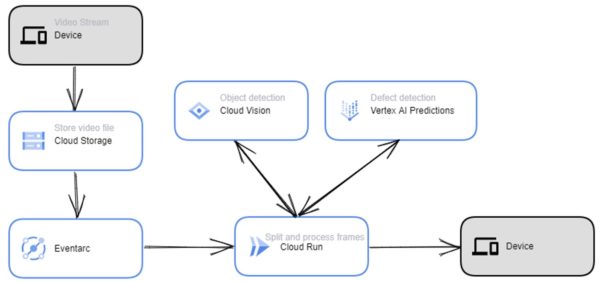

Konferenssissa Google Cloud ilmoitti, että sen GenAI-työkalusarja on valmis laajempiin toteutuksiin. Tämä on merkittävä virstanpylväs, koska se tarkoittaa, että GenAI ei ole enää vain tutkimusprojekti, vaan teknologia, joka Toinen konferenssissa laajasti käsitelty aihe oli Cloud Run. Cloud Run on palvelimeton laskenta-alusta, jonka avulla kehittäjät voivat suorittaa koodiaan ilman, että heidän tarvitsee hallita palvelimia tai infrastruktuuria. Cloud Run on yksinkertainen ja kustannustehokas tapa ottaa käyttöön ja hallita verkkosovelluksia, mikropalveluita ja tapahtumapohjaisia työkuormia.

Toinen konferenssissa laajasti käsitelty aihe oli Cloud Run. Cloud Run on palvelimeton laskenta-alusta, jonka avulla kehittäjät voivat suorittaa koodiaan ilman, että heidän tarvitsee hallita palvelimia tai infrastruktuuria. Cloud Run on yksinkertainen ja kustannustehokas tapa ottaa käyttöön ja hallita verkkosovelluksia, mikropalveluita ja tapahtumapohjaisia työkuormia.